はじめに

この記事は「CI/CD Advent Calendar 2019 - Qiita」17日目の投稿です。はじめに

Rocro のサービス終了が発表されました。

コードレビュー系のサービスは GitHub Actions の登場もあり厳しいのかもしれないなぁーと思った今日このごろ。。

個人的には、GitHub Actions + reviewdog でもうええやんってなってる。

(reviewdog のことは別途記事にしたい)

と、まぁ GitHub Actions が目立った年だったなと思いますが、

各サービスの一年を軽く振り返ってみたいと思います。

(いろんなサービス使ってるけど、常にニュースを追っかけてるわけじゃないのでいい機会ですね)

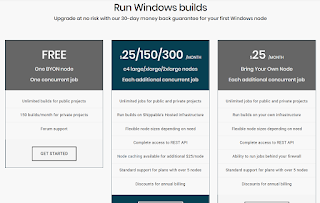

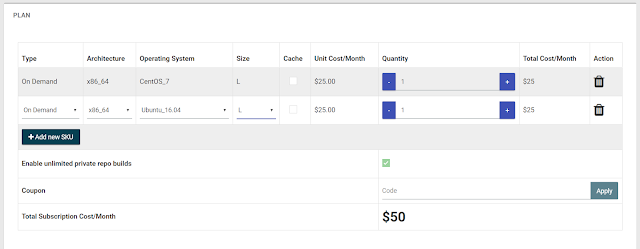

AppVeyor

Build macOS projects with AppVeyor | AppVeyorAppVeyor でも Mac が使えるようになりました。

ブログでは E-mail で連絡してねと書いてありますが、現在はすべてのユーザーが使用可能になっているようです。

かつては、Windows の CI は AppVeyor 一択だったころもありましたが、

もはや、OS のバリエーションは CI サービスの優位性にならなくなってしまいましたね。

今後 AppVeyor がどうなっていくのか気になるところです。

Azure Pipelines

What’s new with Azure Pipelines | Azure DevOps BlogMulti-stage YAML pipelines というのが使えるようになっていたみたいです。

まだ使ったことないので、そのうち使ってみたいですね。

Bitrise

Bitrise Ship just released to Open Beta | Bitrise Blog (日本語)Ship はストアへのデプロイを Bitrise 上で行えるようになる機能のようですね。

個人開発ではモバイル開発をしてないので、あまりお世話になることはないものですが、

Bitrise はモバイル開発の強みが加速しているように見えますね。

Buddy

New feature: Multiple YAML-file support for pipeline definitions | Buddy: The DevOps Automation Platformパイプラインを分けてかけるようになったみたいですね。

.buddy ディレクトリ配下に、.yml をおけばよいみたいです。(ルートの buddy.yml は必須)

buddy は制限きつくてあんまり使ってないのですが、いっぱい使えるようになったら分割してみたいですね。

Circle CI

Windows CI - Windows support | CircleCIAppVeyor とは逆ですね。Circle CI でも Windows 環境が使えるようになりました。

Cirrus CI

Cirrus CI は FreeBSD に対応しましたね。と言いたいところでしたが、去年の話でした。Excited to announce FreeBSD support on Cirrus CI! 🎉 As usual free for OSS and with per-second billing for private repositories! 🙌 https://t.co/HplxCQSPYF

— Cirrus Labs (@cirrus_labs) December 4, 2018

なんか普段から使ってると昔からこうだった気がしちゃいますが、GitHub との連携周りが強化されていたようです。

Cirrus CI now supports @GitHub's content attachments API. 🎉 Issue and PR comments with links to Cirrus CI tasks will have additional information about the tasks including logs! 😻 pic.twitter.com/mmByWPwvwq

— Cirrus Labs (@cirrus_labs) January 29, 2019

Exited to announce @GitHub Annotations support on Cirrus CI! 🎉 Enriched feedback right in the same tab! 🙌 https://t.co/A7mAXxGdNG pic.twitter.com/YaZGhSVAKk

— Cirrus Labs (@cirrus_labs) April 22, 2019

と、思ったらマニュアルタスク対応してたのか!

ちょうど欲しかったんだよね。

Cirrus CI now supports manual tasks which are very handy integrated right in the @GitHub UI! Learn more in the docs 👇 https://t.co/muRW0AFGN7 pic.twitter.com/1xEu92CaJV

— Cirrus Labs (@cirrus_labs) May 20, 2019

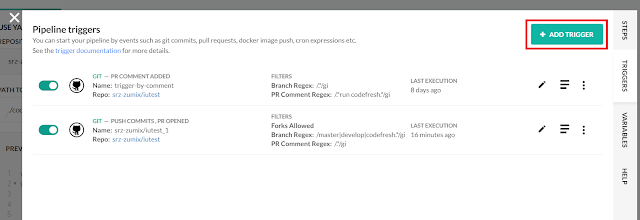

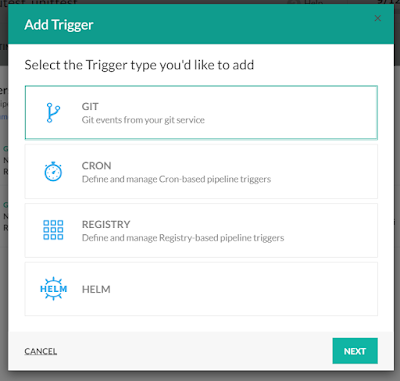

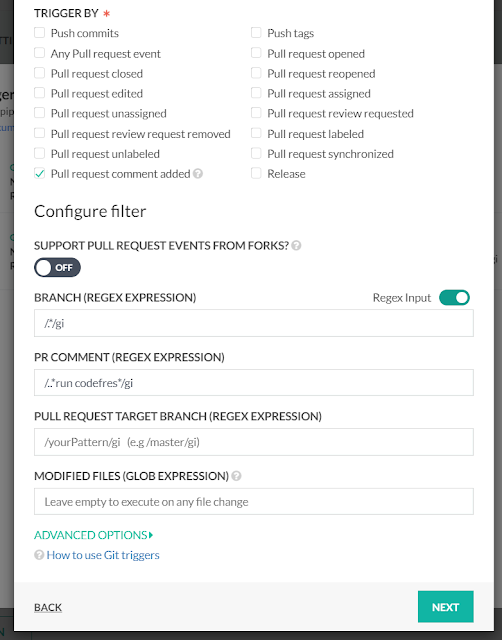

Codefresh

Use parallel steps in your Codefresh pipelines - Codefresh並列ステップができるようになりました。

これは、本ブログでも紹介しましたね。「ブログズミ: [Codefresh] Parallel 実行してみた」

Pause your pipelines and resume after manual approval - Codefresh

もう一個。

Codefresh もマニュアル対応してたんですね。

Codeship

New CloudBees CodeShip Beta - a Faster, Simpler, Unified Build Page - via @codeship | via @codeship新しい UI が出てたみたいですね。

「Personal Settings」の「New build details page」を Turn On すればよさそうです。

今度試してみます。

Drone Cloud

Announcing Support for Starlark ScriptingGitHub Actions が HCL(HashiCorp Configuration Language)から YAML に変わったのは記憶に新しいですが、

Drone は YAML じゃなくて Starlark で書けるようになったみたいです。

Bazel な人にとっては嬉しいのかな?

GitHub Actions

New from Universe 2019: GitHub for mobile, GitHub Archive Program, and more - The GitHub Blogはい。正式リリースおめでとうございます。

今後ともよろしくお願いします。

Pekaflow

前回の記事を参考にしてください。「ブログズミ: [CI] Peakflow 始めました」

Rocro

Rocro will not be available after Jaunary 31, 2020 – Rocro News Releases冒頭で書いたとおり、2020年1月31日にクローズとなります。

いままでお世話になりましたmm

Scrutinizer

2018年の4月以降ブログが更新されてない。大丈夫かな?Semaphore CI

Semaphore 2.0 Welcomes Open Source Developers with Free Continuous IntegrationOSS のビルド時間制限がなくなったみたいですね。

これはちょー嬉しい!あとでちゃんと確認しよ。

Shippable

こちらもブログの更新が滞ってますね。ただ、Shippable は2月に JFrog に買収されたので、JFrog Pipeline の方に注力してるのかもしれないですね。

We’ve Acquired Shippable to Complete DevOps Pipeline Automation From Code to Production | JFrog

Shippable も継続してくれると嬉しい限りですが・・

Sider (旧SideCI)

Siderの運営会社が2019年10月末日より株式会社スリークに変わります - Sider BlogSleeek の機能の一端として取り込まれるみたいですね。

Shppable といい、統合が進んでますね。

Travis CI

CPU アーキテクチャが選べるようになりました。OS の次は CPU アーキテクチャなのだろうか。

The Travis CI Blog: Multi-CPU architecture support for your builds

The Travis CI Blog: Build your open source projects on IBM Power and IBM Z CPU architecture

Wercker

こちらも特に news はなし。。最後に

見切り発車でアドカレに登録してしまったのだが、使ってるサービスが増えるほど情報追っかけるのが辛いので、こういう機会に見直してみるのはありかも。と思いました。年明けにこの記事を見返してみて、試せることはやってみたいと思います。

では。